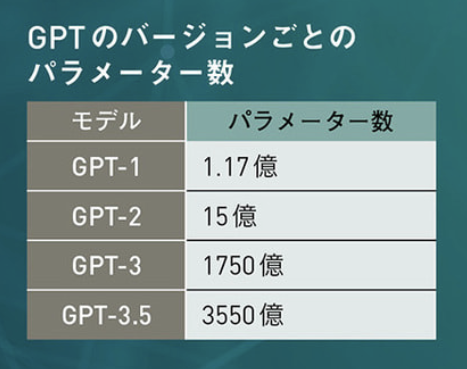

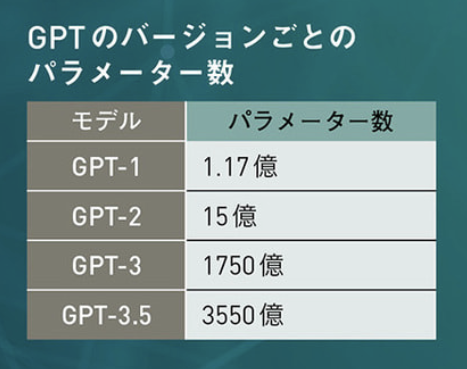

科学雑誌『Newton』2023年7月号「ChatGPTの衝撃」p.23に次の図がある。

GPT-3.5のパラメータ数は3550億とされている。実際、「GPT-3.5 355 billion」等でググると、けっこうな数のサイトでこの数字が出てくる。ところがどこにも出典が書かれていない。

このことをTwitterに書いたところ、A conversation with an artificial intelligence (AI) というChatGPTとの対話記事で、ChatGPT自身が次のように言っていることを教えていただいた。2022-12-06の記事である。どうやらこれが初出らしい。

The main difference between GPT-3.0 and GPT-3.5 is the size of the model. GPT-3.0 is the smaller of the two models, with 175 billion parameters, while GPT-3.5 is significantly larger, with a staggering 355 billion parameters. This means that GPT-3.5 has more capacity to learn and generate responses than GPT-3.0.

ChatGPTのハルシネーション(妄言)の可能性が大きい。

なお、このサイトは2023-03-13に更新されているようだが、2023-02-05のアーカイブにも同じ記述がある。

念のためChatGPT APIに10回聞いてみた(prompt="How many parameters does GPT-3.5 have? No talk; just go.", model="gpt-3.5-turbo", max_tokens=10, temperature=1):

I'm sorry, but there is no such thing I'm sorry, as an AI language model, Sorry, as an AI language model, I cannot As an AI language model, I am unable to As an AI language model, I am not aware As an AI language model, I have access to As an AI language model, I don't have As an AI language model, I'm not capable I am sorry, but there is no such thing As an AI language model, GPT-3

今は答えてくれないようだ。

『Newton』編集部には3550億の根拠を2023-05-29にWebフォームで問い合わせたので、もし返事があれば追記する。2023-06-14にご返事をいただいた。複数の資料に基づいて確認したものの、公式の根拠はなかったので、本記事を別冊等に再録する際に訂正するとのことである。

検索結果のごく一部:

「355 billion」英語記事:

「3550億」日本語記事:

ほか多数。

[2023-11-10追記] 2023-10-26にMicrosoftの人たちが公開した arXiv:2310.17680 に gpt-3.5-turbo のパラメータ数が 20B(200億)と載っていることが話題になった。最初のGPT-3が1750億なのに200億は少なすぎるのでタイポだろうとか、いや蒸留してそれくらいにしたんだろうとか言われたが、その論文はまもなく撤回されてしまった。← [追記] この顛末についてはGPT 3.5-turboが20Bパラメータという話の後日談に書かれているようにForbesの記事 Is Bigger Better? Why The ChatGPT Vs. GPT-3 Vs. GPT-4 'Battle' Is Just A Family Chat が根拠だったようだが、この記事がそもそも根拠不明。

[追記] GPT-4についても不確実な情報が出回っている。Large Language Models: A Survey ではパラメータ数1.76Tとされているが、これはgeohot(George Hotz)のリークで、GPT-4は8x220BのMoEだという。このツイートあたりも参照。

[2025-05-18追記] O'Reillyの Prompt Engineering for LLMs の初めのほうにある Table 1-1 にはGPT-3.5のパラメータ数が175 billionと書かれている(1750億、つまりGPT-3と同じ)。著者は GitHub Copilot を作った人たちなので、信憑性があるかもしれない。